研究人员为基于语言的任务规划者开发了一个自动化基准

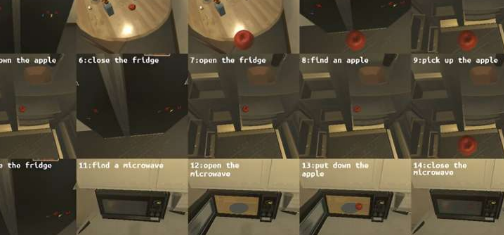

如果指示“将冷却的苹果放入微波炉”,机器人会如何反应?最初,机器人需要找到一个苹果,拿起它,找到冰箱,打开门,然后将苹果放入里面。随后,它会关闭冰箱门,重新打开冰箱门以取出冷却的苹果,再次拿起苹果,然后关上门。接下来,机器人需要找到微波炉,打开微波炉门,将苹果放入里面,然后关闭微波炉门。

评估这些步骤的执行情况体现了对任务规划人工智能技术进行基准测试的本质。它衡量机器人响应命令和遵守指定程序的效率。

电子和电信研究所(ETRI)研究团队开发了一种技术,可以自动评估大型语言模型(LLM)生成的任务计划的性能,并为快速、客观地评估任务规划人工智能铺平道路。

ETRI宣布开发LoTa-Benchmark(LoTa-Bench),能够自动评估基于语言的任务规划器。基于语言的任务规划器理解人类用户的口头指令,规划一系列操作,并自主执行指定的操作以实现指令的目标。

研究团队在国际学习表征会议(ICLR)上发表论文,并通过GitHub分享了总计33个大型语言模型的评估结果。

最近,法学硕士不仅在语言处理、对话、解决数学问题和逻辑证明方面表现出了出色的表现,而且在理解人类命令、自主选择子任务并顺序执行子任务以实现目标方面也表现出了出色的表现。因此,人们在机器人应用和服务实现中应用大型语言模型进行了广泛的努力。

此前,由于缺乏能够自动评估任务规划绩效的基准技术,因此需要进行手动评估,这是劳动密集型的。例如,在现有的研究中,包括谷歌的SayCan,采用的方法是多个人直接观察任务执行的结果,然后对任务的成功或失败进行投票。

这种方法不仅需要花费大量的时间和精力来进行绩效评估,工作繁琐,而且还引入了主观判断影响结果的问题。

ETRI开发的LoTa-Bench技术通过实际执行基于用户命令的大型语言模型生成的任务计划来自动化评估过程,并自动将结果与命令的预期结果进行比较,以确定计划是否成功。这种方法显着减少了评估时间和成本,并确保了评估结果的客观性。

ETRI公布了不同大语言模型的基准测试结果,表明OpenAI的GPT-3取得了21.36%的成功率,GPT-4的成功率为40.38%,Meta的LLaMA2-70B模型的成功率为18.27%,MosaicML的MPT-30B模型的成功率为18.75%。

值得注意的是,较大的模型往往具有优越的任务规划能力。20%的成功率意味着在100个指令中,有20个计划成功实现了指令的目标。

在LoTa-Bench中,性能评估是在艾伦人工智能研究所(AI2-THOR)和麻省理工学院(MIT的VirtualHome)开发的虚拟仿真环境中进行的,旨在研究和开发机器人技术和实体智能。该评估使用了ALFRED数据集,其中包括日常家庭任务说明,例如“将冷却的苹果放入微波炉中”等。

利用LoTa-Bench技术轻松快速验证新任务规划方法的优势,研究团队发现了两种通过数据驱动训练提高任务规划性能的策略:上下文示例选择和基于反馈的重新规划。他们还证实,微调可以有效提高基于语言的任务规划的性能。

ETRI社交机器人实验室首席研究员MinsuJang表示:“LoTa-Bench标志着任务规划人工智能发展的第一步。我们计划研发能够在不确定情况下预测任务失败或提高任务生成智能的技术通过寻求并接受人类的帮助,这项技术对于实现每户一个机器人的时代至关重要。”

ETRI社交机器人研究部主任JaehongKim宣布:“ETRI致力于利用基础模型推进机器人智能,使机器人能够在现实世界中生成和执行各种任务计划。”

通过以开源方式发布该软件,ETRI研究人员预计公司和教育机构将能够自由利用该技术,从而加速相关技术的进步。

免责声明:本答案或内容为用户上传,不代表本网观点。其原创性以及文中陈述文字和内容未经本站证实,对本文以及其中全部或者部分内容、文字的真实性、完整性、及时性本站不作任何保证或承诺,请读者仅作参考,并请自行核实相关内容。 如遇侵权请及时联系本站删除。